Loading

Les plateformes de données modernes convergent vers le Cloud et l’architecture Lakehouse. Qu’est-ce qui les différencie réellement ? Laquelle répond le mieux à vos besoins ?

Que vous soyez en train de choisir une plateforme de données ou de moderniser votre data warehouse ou data lake, nous avons comparé Microsoft Fabric, Databricks et Snowflake. Voici les 4 principales différences que nous avons identifiées :

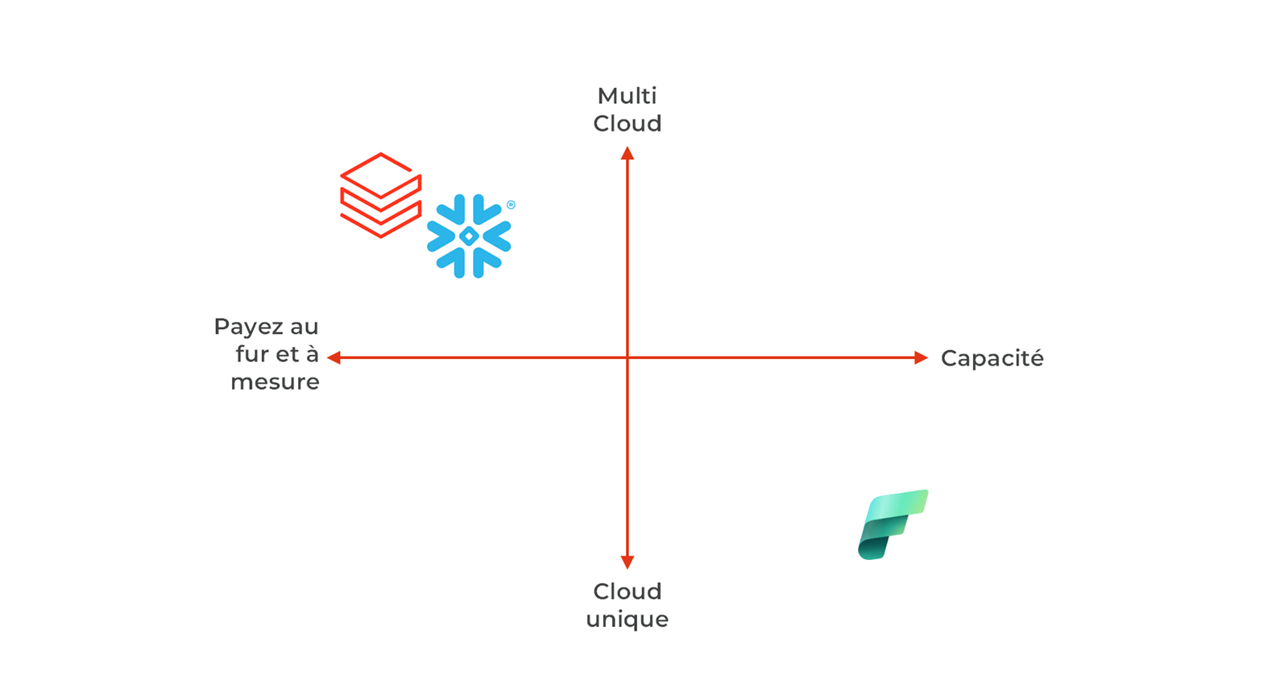

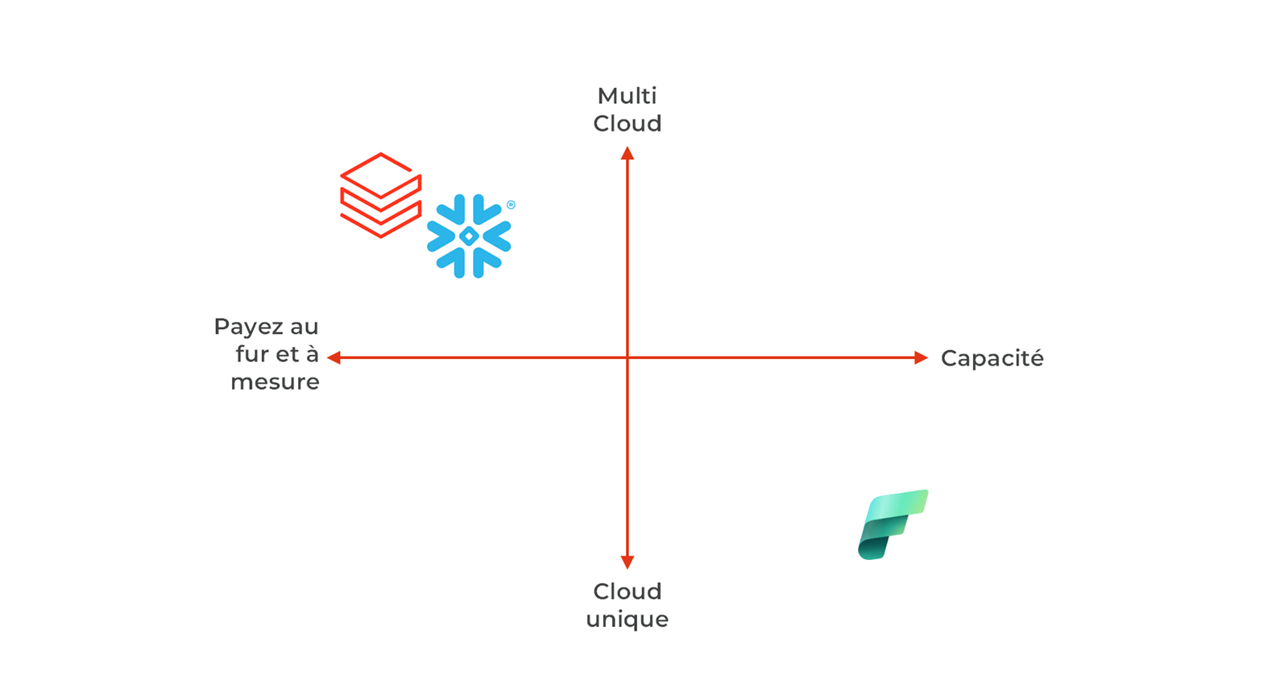

Disponibilité et prix

Que vous soyez sensible aux coûts, que vous ayez une stratégie de cloud existante ou des exigences de souveraineté, vous devez choisir le modèle de cloud et de prix qui vous convient :

- Fabric n'est disponible que sur Azure et est basé sur un modèle de tarification de la capacité.

- Snowflake et Databricks sont des modèles de paiement à l'utilisation avec réservation optionnelle, ils sont disponibles sur les 3 principaux hyperscalers.

- Databricks est également disponible sur SAP Business Data Cloud.

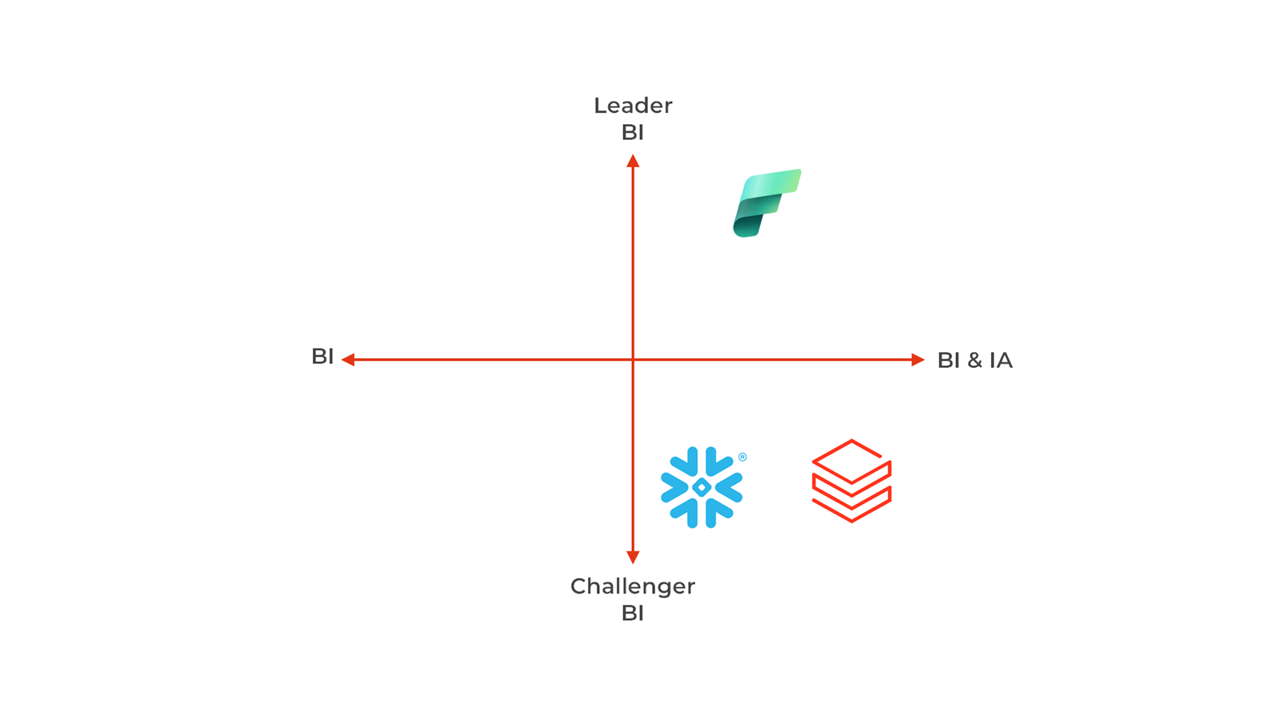

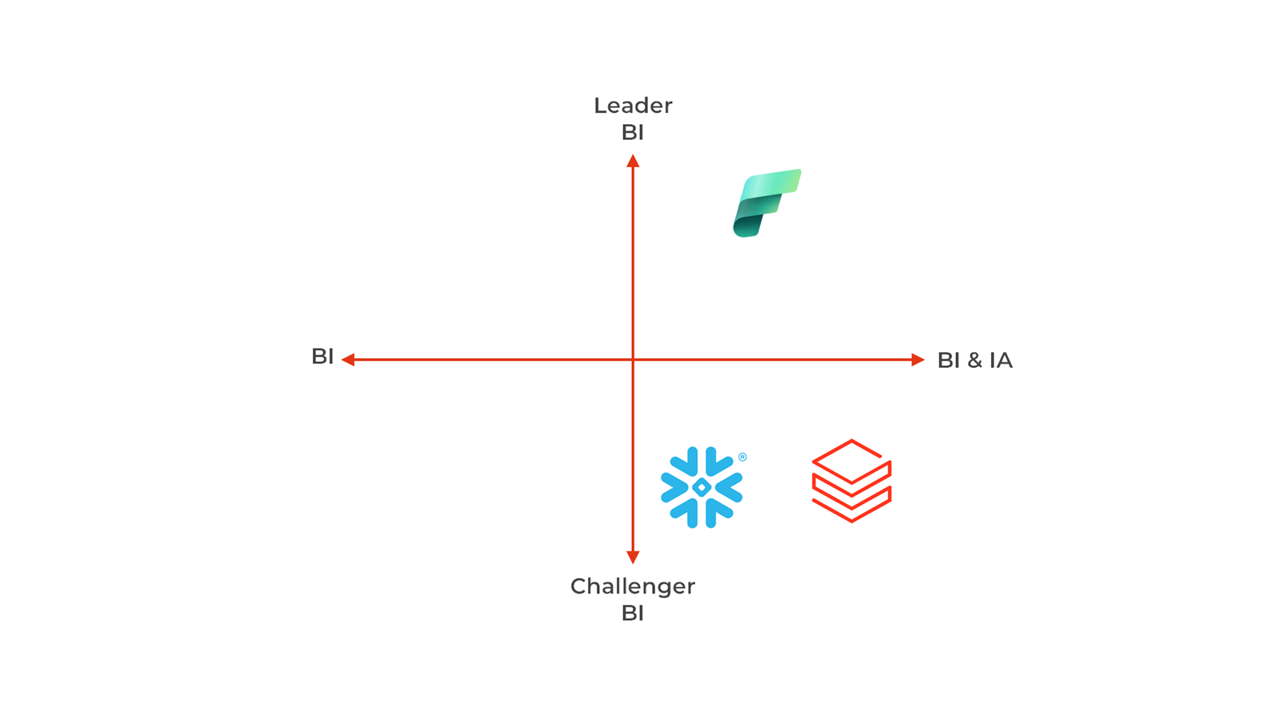

Utilisation des données et différences de consommation

Vous démarrez peut-être avec des besoins en BI, mais vous explorez aussi des cas d’usage autour du machine learning et de la GenAI. Quelle plateforme offre le meilleur potentiel ?

- Power BI de Fabric est le leader en matière de Business Intelligence (BI). Snowflake et Databricks remettent en question cette position avec des tableaux de bord plus légers. Databricks, avec Databricks One, et Snowflake, avec Snowflake Intelligence, proposent des interfaces alimentées par l’IA qui rendent la plateforme plus accessible aux utilisateurs métier. Ces produits concurrencent Fabric Copilot.

- Les trois plateformes investissent massivement dans l’IA générative (GenAI). Databricks a récemment annoncé Agent Bricks, un produit qui aide les entreprises à créer leurs propres agents spécialisés par domaine.

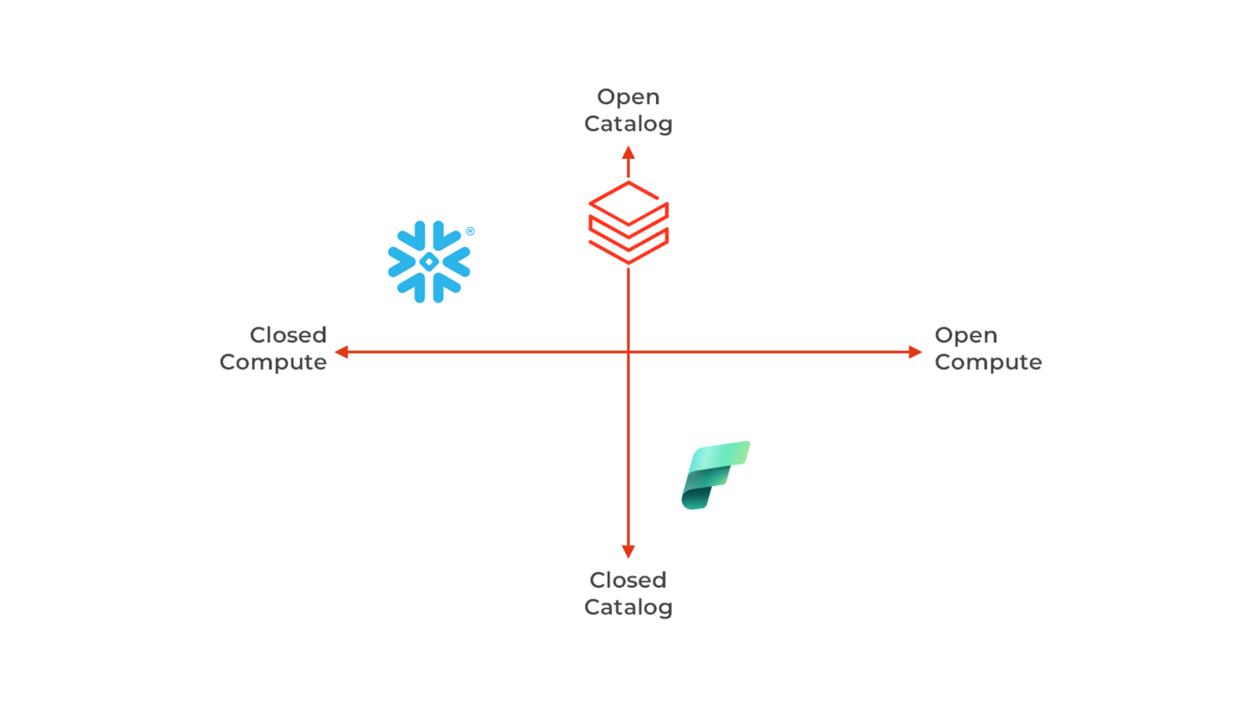

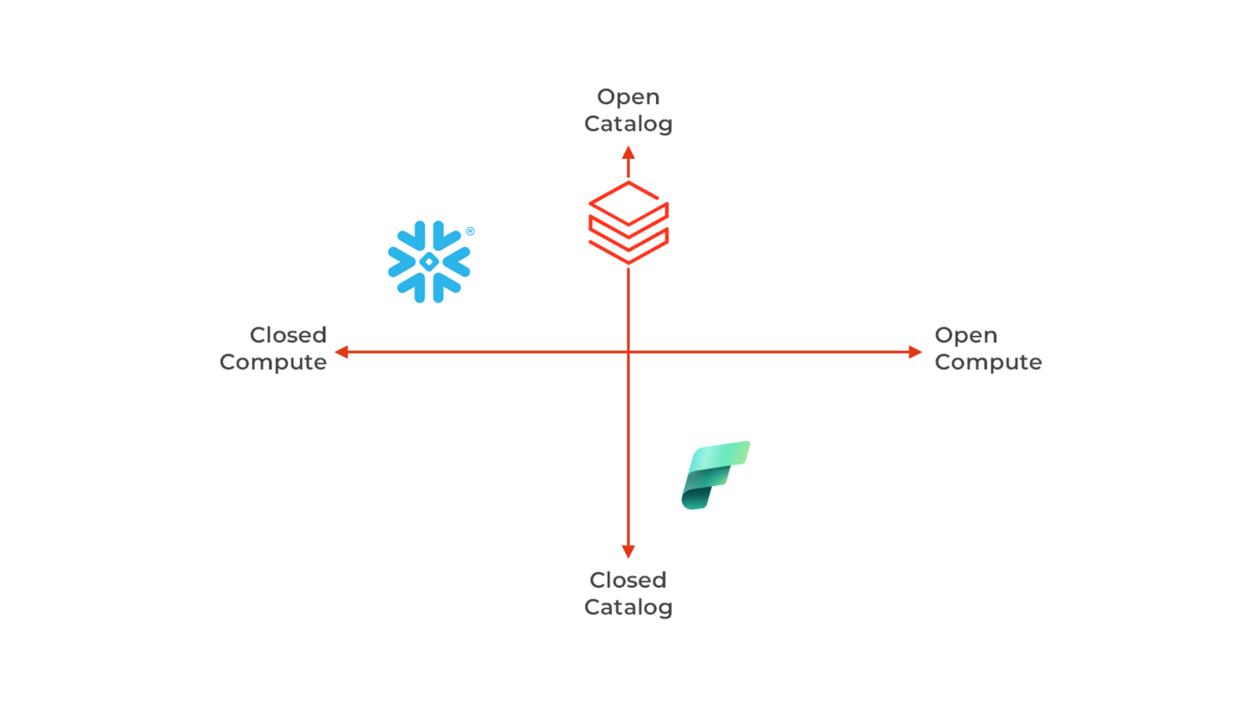

Interopérabilité et robustesse assurées par l’adoption des standards ouverts

Les standards ouverts jouent un rôle clé dans la transition vers — ou depuis — une plateforme de données, en facilitant l’interopérabilité. La capacité à ingérer et exporter facilement des données repose largement sur l’adoption de formats ouverts, qui soutiennent les orientations stratégiques à long terme.

- Databricks prend en charge de nombreuses technologies open source (Apache Spark, MLFlow, Delta Lake, Unity Catalog), mais également certaines technologies propriétaires récentes (Delta Live Table, Lakeflow, Mosaic AI, etc.). Databricks prend désormais pleinement en charge Iceberg comme alternative à Delta Lake.

- Fabric est également un promoteur de Spark, MLFlow et Delta, mais d'autres fonctionnalités sont propriétaires (Power BI, Onelake, Warehouse…).

- Snowflake a ouvert son architecture en offrant un fort support pour les tables Iceberg et en open-sourçant le catalogue Polaris. Cependant, les principaux moteurs et frameworks restent fermés (Warehouse, Snowpark, Cortex…).

- Les trois plateformes évoluent vers des systèmes de gestion de bases de données capables de gérer des charges transactionnelles et des applications d’IA : Databricks a annoncé Lakehouse, une version managée de Postgres, Snowflake propose également une version managée de Postgres suite à l’acquisition de Crunchy Data, et Fabric intègre Azure SQL managé via les Database Mirrors.

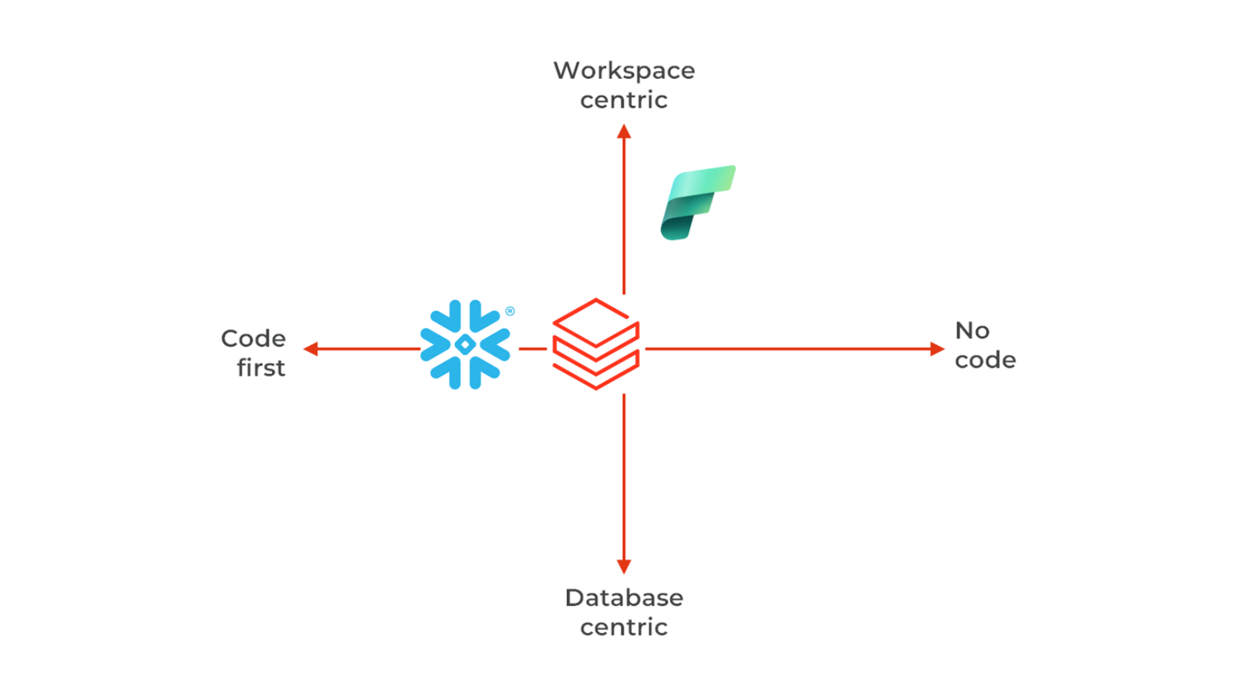

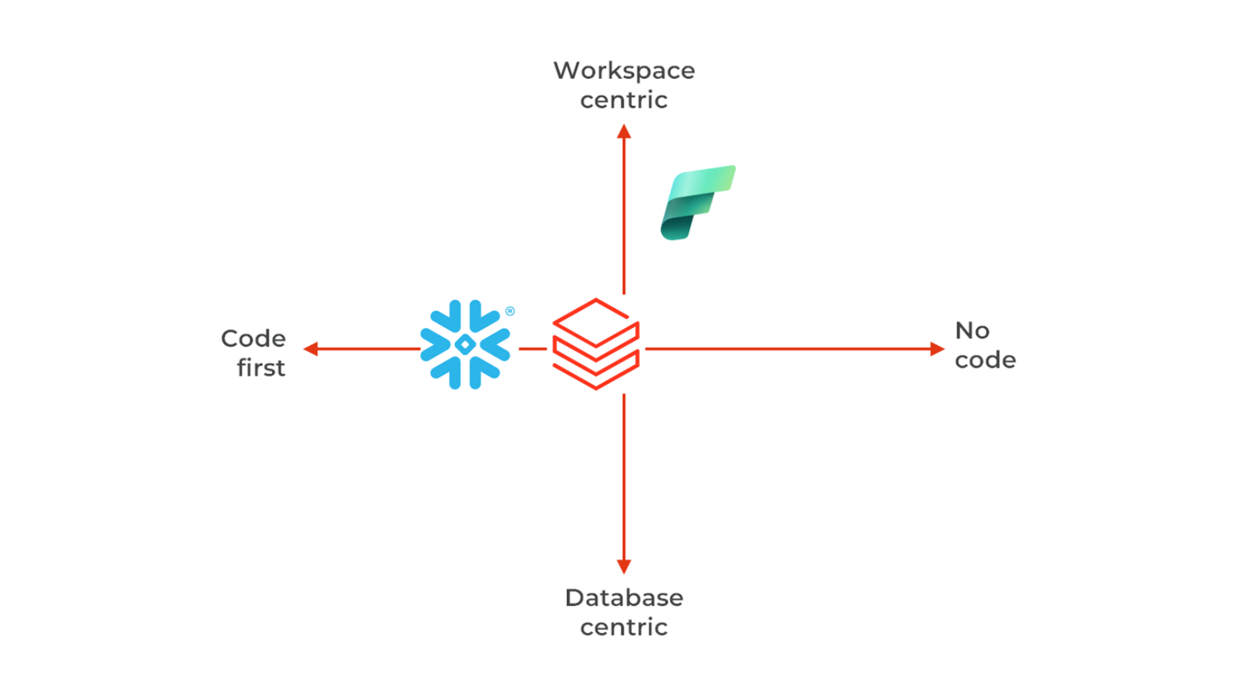

Approches différenciées du développement et de la collaboration autour du code

C’est sans doute l’un des aspects les plus complexes — et pourtant cruciaux — à évaluer : comment les développeurs et les utilisateurs interagissent-ils avec la plateforme ? L’environnement est-il adapté aux analystes, ingénieurs, et data scientists ? Permet-il une collaboration efficace au sein d’une équipe Scrum (7 personnes), voire à l’échelle d’une organisation structurée selon SAFe ? Ces éléments ont un impact direct sur le recrutement, l’onboarding et l'acculturation à la data au sein de l’entreprise.

- Snowflake bénéficie d'une architecture propre, conçue depuis zéro, où tout est déclaré en tant que code dans le catalogue, en SQL ou Python. Tout le code est versionné dans Git. Dans Snowflake, la collaboration s’effectue via des Workspaces, et les artefacts (tables, modèles d’IA, etc.) sont stockés dans des bases de données.

- Fabric étend l’organisation des objets Power BI dans les Workspaces. Le versionnement se fait via des déclarations JSON, avec un dépôt par Workspace.

- De manière similaire à Snowflake, Databricks utilise des Workspaces (un Workspace unique par session), et gère les actifs via le Unity Catalog (schémas, tables, volumes, modèles d’IA). Les actifs du Workspace (calculs, tableaux de bord, notebooks, etc.) sont déployés via des Asset Bundles. Le versionnement combine code Python/SQL et déclarations JSON.

- Par ailleurs, Snowflake et Databricks proposent aujourd’hui des outils ETL low-code : Snowflake OpenFlow et Databricks Lakeflow Designer.

Profitez d’un appel gratuit de 30 minutes avec notre expert.

Vous êtes en train de sélectionner une plateforme de données ou vous souhaitez moderniser votre data warehouse ou data lake ? Contactez-nous et obtenez un appel gratuit de 30 minutes avec notre expert.

Contactez notre expert

Antoine Hue

Data Architect

Antoine Hue, notre expert en données. Antoine est l'architecte des plateformes de migration et d'analyse de données. Il est responsable de l'équipe Data engineering en Romandie.

Abonnez-vous à la DataAI Newsletter !

Abonnez-vous dès maintenant et gardez une longueur d’avance dans un monde où les données, l’analytique et l’IA transforment tous les secteurs.