Loading

Da moderne Datenplattformen in Richtung Cloud und Lakehouse-Architektur konvergieren, was sind die Unterscheidungsmerkmale? Welche ist die beste für Sie?

Sie sind dabei, eine Datenplattform auszuwählen, oder Sie möchten Ihr Data Warehouse, Ihren Data Lake modernisieren. Wir haben Microsoft Fabric, Databricks und Snowflake verglichen, hier sind die 4 wichtigsten Unterschiede, die wir gefunden haben:

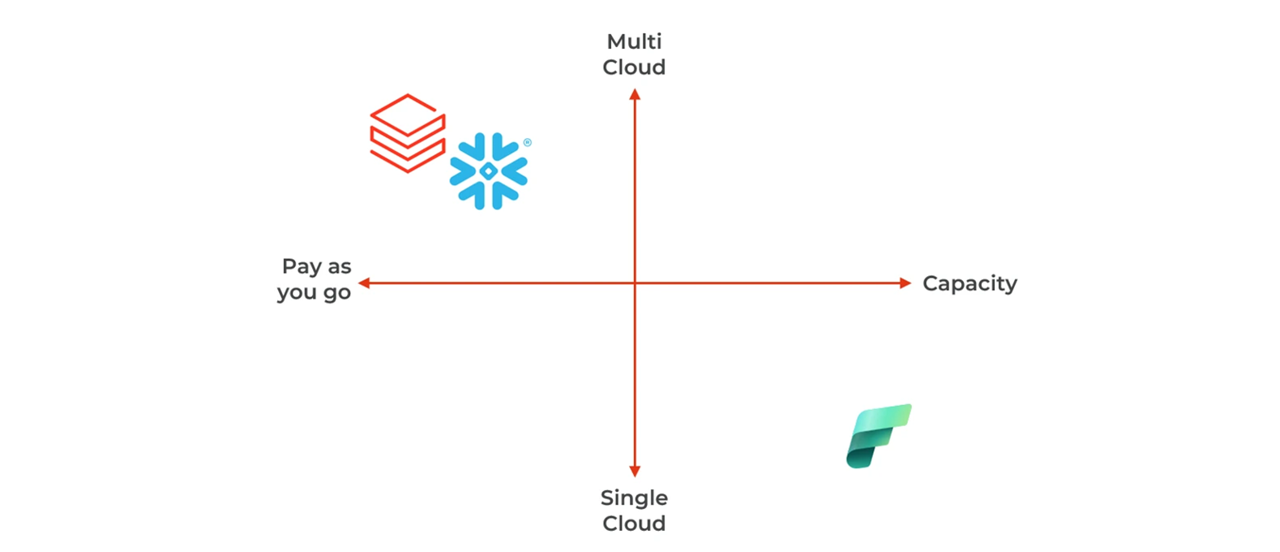

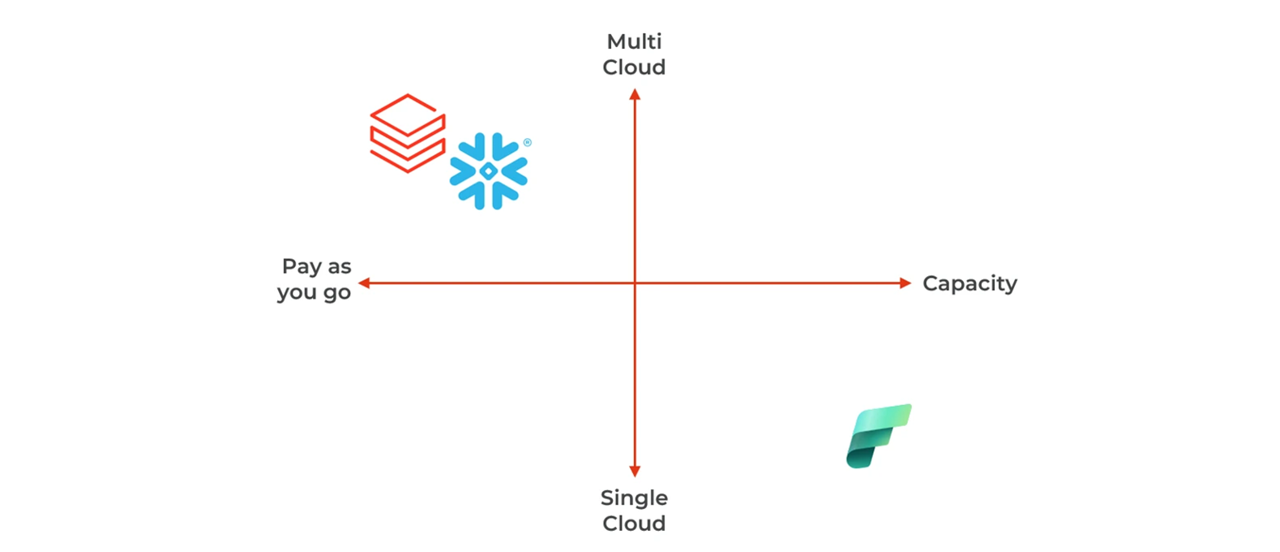

Verfügbarkeit und Preisunterschiede

Unabhängig davon, ob Sie kostensensibel sind oder eine bestehende Cloud-Strategie oder Souveränitätsanforderungen haben, müssen Sie die passende Cloud und das passende Preismodell wählen:

- Fabric ist nur auf Azure verfügbar und basiert auf einem Kapazitätspreismodell.

- Snowflake und Databricks sind Pay-as-you-go mit optionaler Reservierung, sie sind auf den 3 wichtigsten Hyperscalern verfügbar.

- Databricks ist auch auf der SAP Business Data Cloud verfügbar.

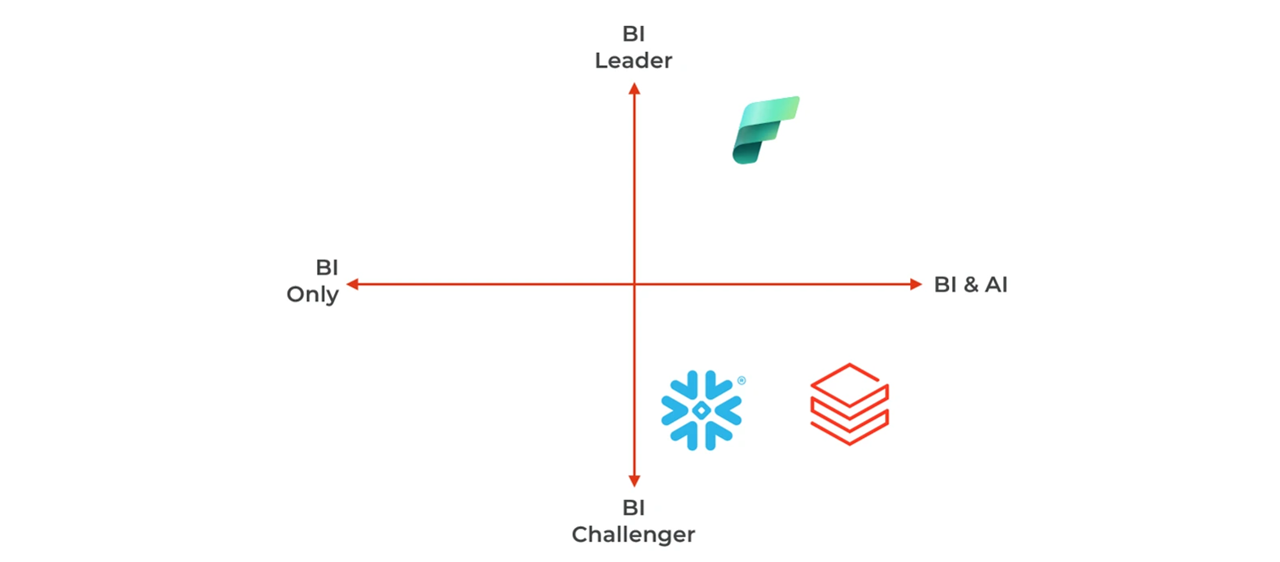

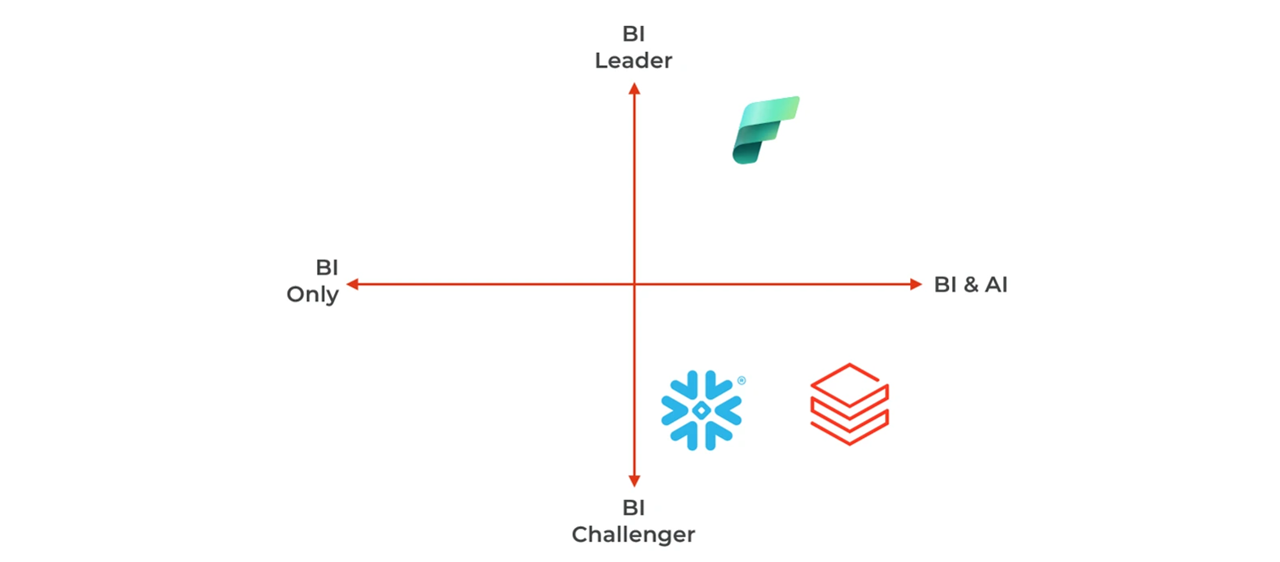

Unterschiede bei Datennutzung und Verbrauch

Sie beginnen vielleicht mit BI-Anforderungen, sind aber auch an maschinellem Lernen und GenAI für neue Anwendungsfälle interessiert. Welche Plattform hat das beste Potenzial?

- Power BI von Fabric ist der Marktführer im Bereich Business Intelligence (BI). Snowflake und Databricks fordern diese Position mit leichteren, schlankeren Dashboards heraus. Databricks mit Databricks One und Snowflake mit Snowflake Intelligence setzen auf KI-gestützte Benutzeroberflächen, die die Plattform auch für Fachanwender zugänglich machen. Diese Produkte konkurrieren mit Fabric Copilot.

- Alle drei Plattformen investieren stark in generative KI (GenAI). Databricks hat kürzlich Agent Bricks angekündigt – ein Produkt, das Unternehmen dabei unterstützt, domänenspezifische KI-Agenten zu entwickeln.

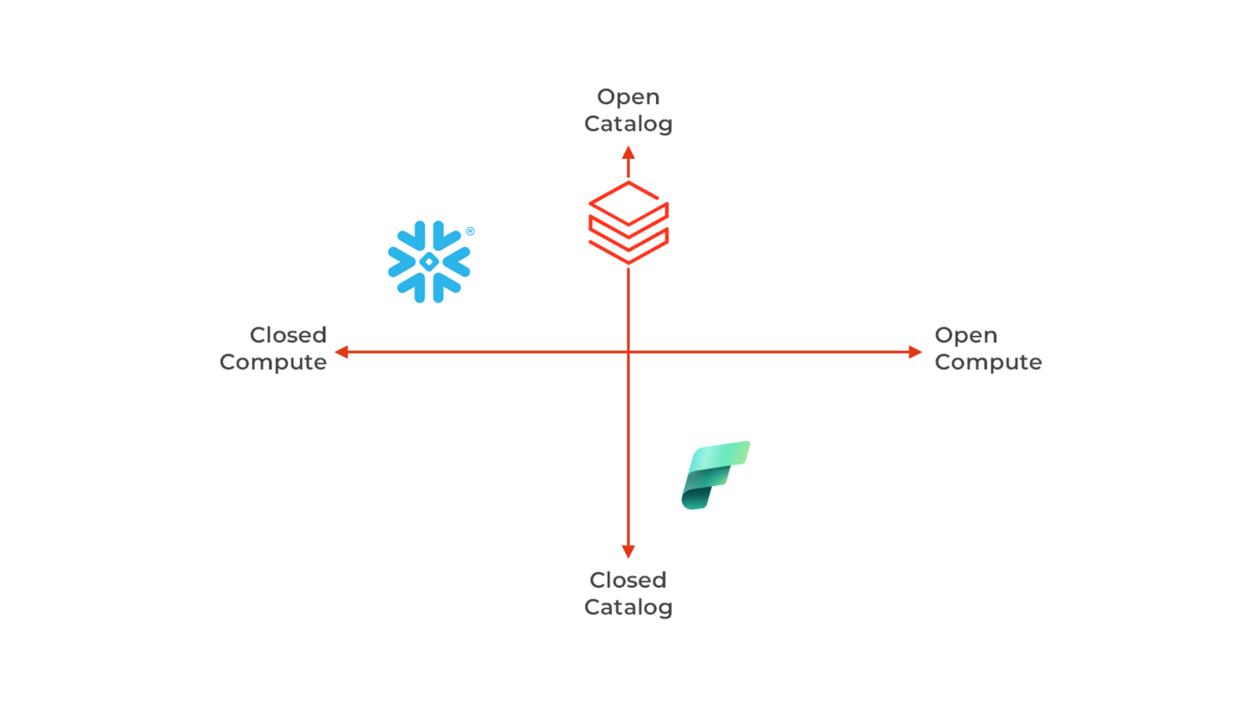

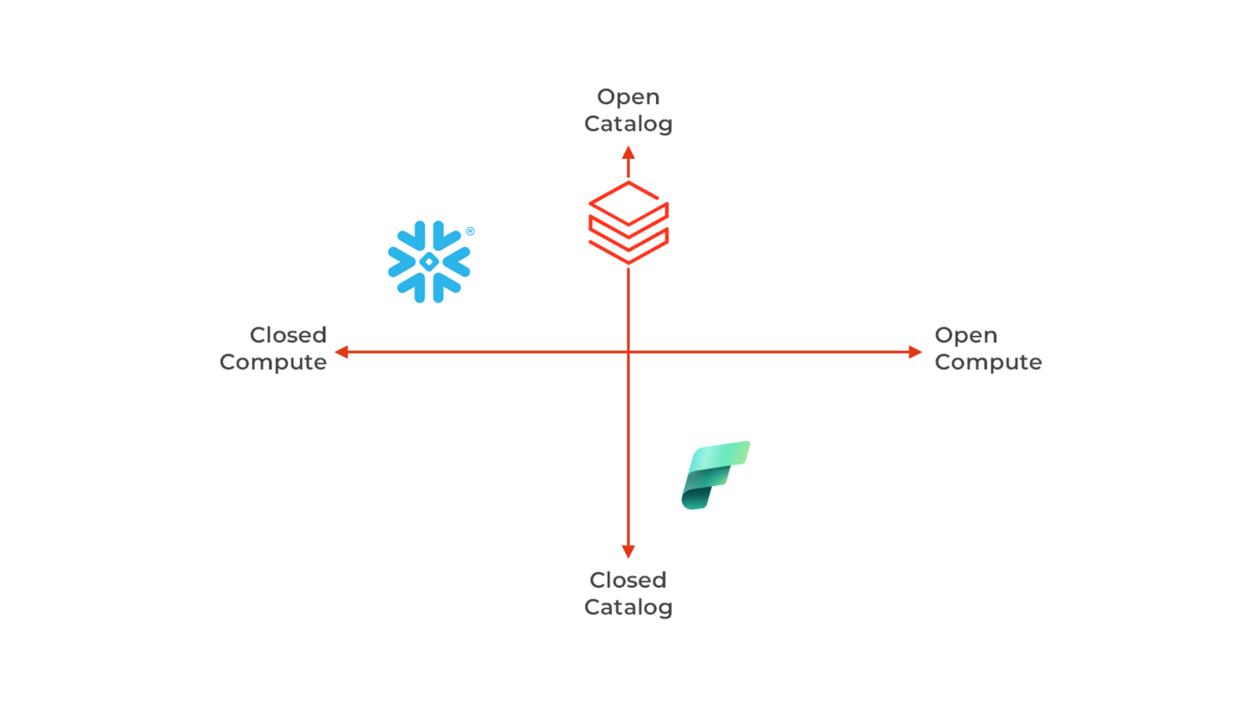

Interoperabilität und Ausfallsicherheit durch Unterstützung offener Standards

Der Übergang zu oder von einer Datenplattform wird maßgeblich durch offene Standards zur Förderung der Interoperabilität beeinflusst. Die Fähigkeit, Daten aufzunehmen und zu exportieren, ist von entscheidender Bedeutung, was bedeutet, dass offene Datenformate für die Unterstützung strategischer Ausrichtungen unerlässlich sind:

- Databricks unterstützt viele Open-Source-Technologien (Apache Spark, MLFlow, Delta Lake, Unity Catalog), aber auch einige neue proprietäre Lösungen (Delta Live Table, Lakeflow, Mosaic AI usw.). Databricks unterstützt nun vollständig Iceberg als Alternative zu Delta Lake.

- Fabric ist ebenfalls ein Befürworter von Spark, MLFlow und Delta. Andere Funktionen sind jedoch Closed Source (Power BI, Onelake, Warehouse usw.).

- Snowflake hat seine Architektur geöffnet, indem es Iceberg-Tabellen umfassend unterstützt und den Polaris-Katalog als Open Source veröffentlicht hat. Die zentralen Engines und Frameworks bleiben jedoch proprietär (Warehouse, Snowpark, Cortex usw.).

- Alle drei Plattformen entwickeln sich hin zu Datenbanksystemen, die transaktionale Workloads und KI-Anwendungen unterstützen: Databricks hat Lakebase angekündigt, eine verwaltete Postgres-Lösung. Snowflake bietet ebenfalls ein verwaltetes Postgres an, nach der Übernahme von Crunchy Data. Fabric integriert ein verwaltetes Azure SQL über die Database Mirrors.

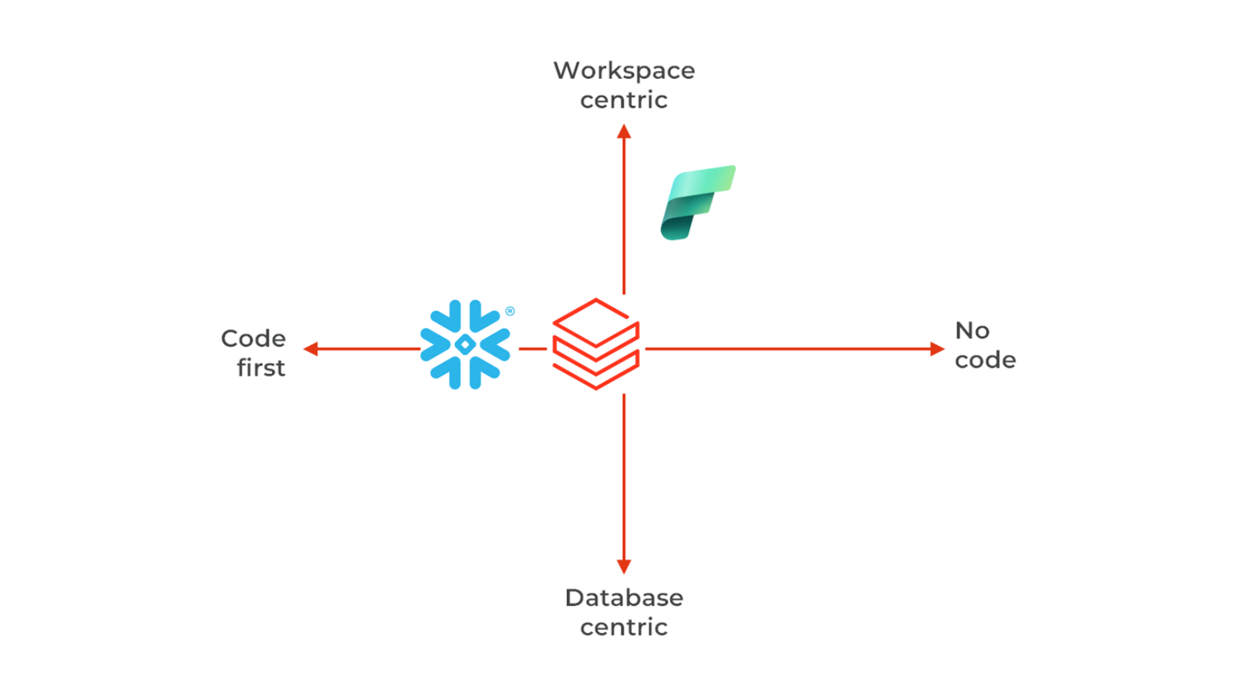

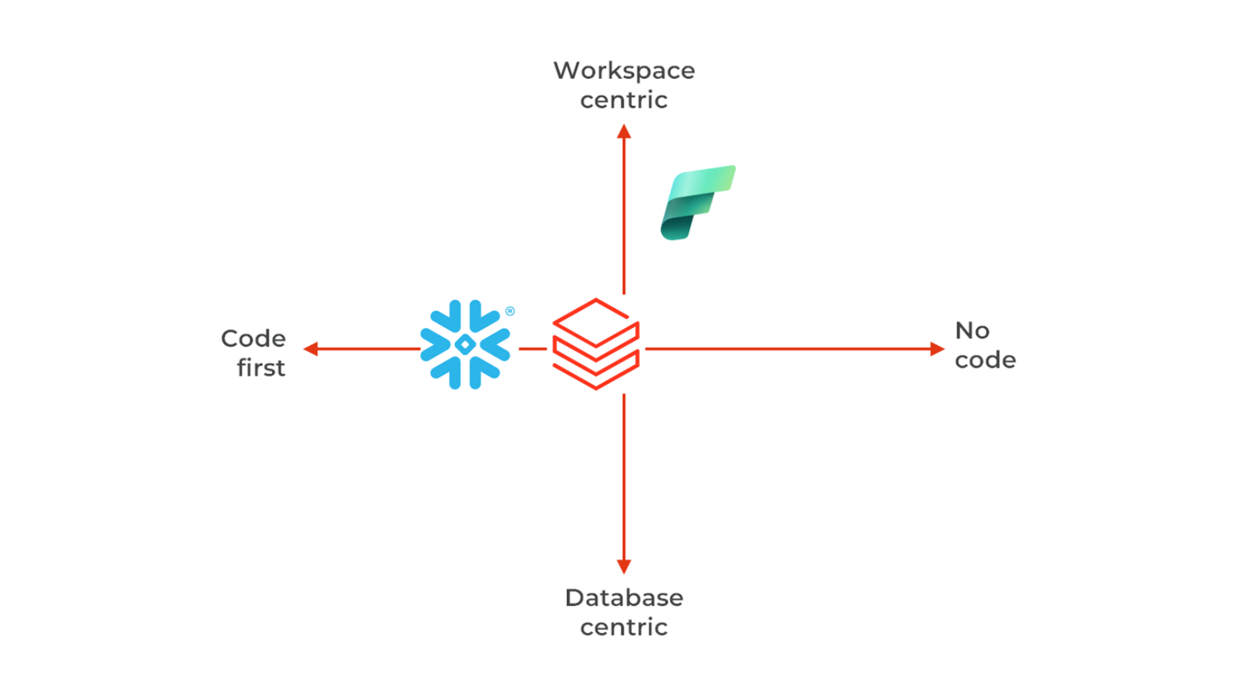

Unterschiede bei der Codeentwicklung und Zusammenarbeit

Dies ist wahrscheinlich der komplexeste - aber auch einer der wichtigsten - zu bewertenden Aspekte: Wie interagieren Entwickler und Nutzer mit der Plattform? Bietet sie eine benutzerfreundliche Umgebung für Datenanalysten, Dateningenieure, Datenwissenschaftler oder für alle? Ist es möglich, innerhalb eines Scrum-Teams (7 Personen) oder sogar größerer Teams wie im SAFe-Setup zusammenzuarbeiten? Die Antwort hat direkte Auswirkungen auf die Personalbesetzung, das Onboarding und die allgemeine organisatorische Anpassung.

- Snowflake verfügt über eine von Grund auf sauber aufgebaute Architektur, bei der alles als Code im Katalog deklariert wird, in SQL oder Python. Der gesamte Code ist in Git versioniert. In Snowflake erfolgt die Zusammenarbeit in Workspaces, und Artefakte (Tabellen, KI-Modelle usw.) werden in Datenbanken gespeichert.

- Fabric erweitert die Power BI-Organisation von Objekten innerhalb von Workspaces. Die Versionierung erfolgt über JSON-Deklarationen, mit einem Repository pro Workspace.

- Ähnlich wie Snowflake nutzt Databricks Workspaces (ein Workspace pro Sitzung) und verwaltet Assets im Unity Catalog (Schemas, Tabellen, Volumes, KI-Modelle). Die Workspace-Ressourcen (Compute, Dashboards, Notebooks usw.) werden über Asset Bundles bereitgestellt. Die Versionierung ist eine Mischung aus Python/SQL-Code und JSON-Deklarationen.

- Darüber hinaus bieten Snowflake und Databricks mittlerweile Low-Code-ETL-Werkzeuge an, nämlich Snowflake OpenFlow und Databricks Lakeflow Designer.

Buchen Sie jetzt ein kostenloses 30-Minuten-Gespräch mit unserem Experten.

Sie sind gerade dabei, eine Datenplattform auszuwählen, oder Sie möchten Ihr Data Warehouse, Ihren Data Lake modernisieren, kontaktieren Sie uns und erhalten Sie ein kostenloses 30-minütiges Gespräch mit unserem Experten.

Kontakt zu unserem Experten

Antoine Hue

Data Architect

Antoine Hue, unser Datenexperte. Antoine ist der Architekt der Plattformen für die Datenmigration und -analyse. Er ist verantwortlich für das Data-Engineering-Team in der Romandie.

Abonnieren Sie den DataAI Newsletter!

Abonniere jetzt und bleib einen Schritt voraus in einer Welt, in der Data, Analytics & KI jede Branche verändern.